مفیدترین مجموعه دادهها واقعبینانهترینِ آنها است و دادههایی که از محیطهای واقعی مانند خانهها استخراج شوند، از ارزش ویژهای برخوردارند. اغلب همزمان با استفاده از برخی محصولات، به شرکتها در مورد نحوه انتشار و تجزیهوتحلیل اطلاعات مصرفکننده اختیار گستردهای میدهیم که در خطمشیهای حفظ حریم خصوصی با زبانی مبهم به آنها اشاره شده است.

دادههای جمعآوریشده توسط روبات جاروبرقی میتواند بهطور ویژهای تجاوز به حریم شخصی تلقی گردد. دنیس گیز

[2]، دانشجوی دکترا در دانشگاه نورث ایسترن

[3] که آسیبپذیریهای امنیتی دستگاههای اینترنت اشیاء، ازجمله روبات جاروبرقی را مطالعه میکند، میگوید:

"اینگونه دستگاهها سختافزار و حسگرهای قدرتمند دارند؛ آنها میتوانند در خانه شما حرکت کنند و شما هیچ راهی برای کنترل آن ندارید!"

او اضافه میکند که این موضوع بهویژه در مورد دستگاههایی با دوربین پیشرفته و هوش مصنوعی (مانند روبات

iRobot از سری

Roomba J7) صادق است.

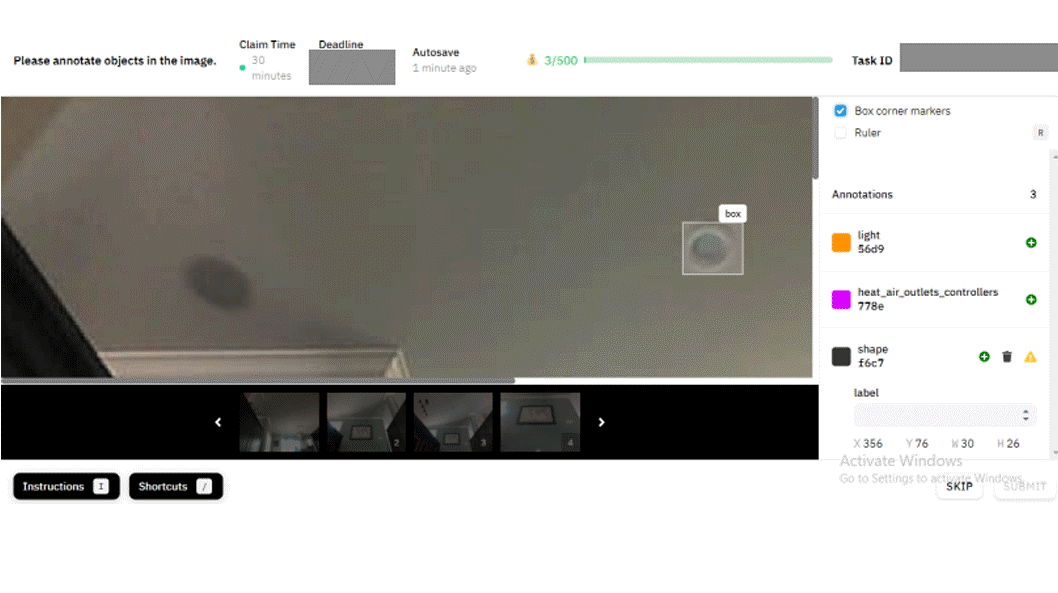

باید به این نکته توجه داشت که از این دادهها برای ساخت روباتهای هوشمندتر استفاده میشود که ممکن است روزی هدف آنها از تمیز کردن محیط خانه بسیار فراتر رود. برای ساختن مجموعه دادههایی از این حجم اطلاعات، که در یادگیری ماشین مفید واقع گردد، افراد باید ابتدا هر داده را مشاهده، دستهبندی و برچسبگذاری کنند که به این فرآیند «حاشیهنویسی داده

[4]» گویند.

مت بین

[5] استادیار دانشگاه کالیفرنیا، سانتا باربارا

[6] در برنامه مدیریت فناوری که به مطالعه عملکرد انسانی در پشتصحنه عملکرد روباتیک میپردازد، توضیح میدهد:

"همیشه گروهی از افراد در اتاقی بدون پنجره نشستهاند و فقط با حرکت سریع و کوتاه موس کامپیوتر اینکه «این یکشی است یا نه» را کنترل میکنند."

15 تصویری که با

MIT Technology Review به اشتراک گذاشته شدهاند، تنها برش کوچکی از یک اکوسیستم دادهای گسترده هستند.

iRobot گفته که بیش از 2 میلیون تصویر را با

Scale Al و مقدار نامعلوم بیشتری را با سایر سکوهای حاشیهنویسی داده به اشتراک گذاشته است. این شرکت تأیید کرده که

Scale تنها یکی از حاشیهنویسهای دادهای است که از آن استفاده میکند.

جیمز باوسمن

[7] سخنگوی

iRobot، در ایمیلی گفت که این شرکت تمام اقدامات احتیاطی را برای اطمینان از اینکه دادههای شخصی بهصورت ایمن و مطابق با قوانین پردازش شود، انجام داده است. علاوه براین، توضیح داده که تصاویر به اشتراک گذاشتهشده با

MIT Technology Review در تضاد با توافقنامه عدم افشای اطلاعاتی بوده که بین

iRobot و یک ارائهدهنده خدمات حاشیهنویسی تصاویر امضا شده است.

چند هفته پس از اشتراکگذاری تصاویر این شرکت، مدیرعامل

iRobot، کالین آنجل

[8]، در بیانیهای ایمیلی اعلام کرد که

iRobot رابطه خود را با ارائهدهنده خدماتی که تصاویر را فاش کرده، خاتمه داده و به جد در حال بررسی موضوع است. همچنین تأکید کرده به دنبال اقداماتی است تا از افشای مجدد اطلاعات توسط هر ارائهدهنده خدمات در آینده جلوگیری کند. بااینحال در خصوص اینکه این اقدامات چیست، شرکت هیچ پاسخی ارائه نداده است.

درنهایت، این مجموعه تصاویر نمایانگر چیزی فراتر از اقدامات یک شرکت است. آنها از روند رو به رشد به اشتراکگذاری دادههای حساس برای آموزش الگوریتمها و از سفر عجیبی که یک تصویر میتواند داشته باشد صحبت میکنند. سفری (در این مورد) از خانههای آمریکای شمالی، اروپا و آسیا به سرورهای

iRobot مستقر در ماساچوست، ازآنجا به

Scale Al مستقر در سانفرانسیسکو و درنهایت به کارکنان قراردادی

Scale در سراسر جهان (ازجمله، در این مثال، کارگرانی در ونزوئلا که تصاویر را برای گروههای خصوصی در فیسبوک، دیسکورد و جاهای دیگر پست کردند).

مجموعه این تصاویر زنجیرهای از تأمین کامل داده و نکات جدیدی که اغلب خریداران از آن آگاه نیستند مثل جایی که اطلاعات شخصی آنها فاش میشوند را نشان میدهد. جاستین بروکمن

[9]، مدیر سیاست فناوری

Consumer Reports و مدیر سابق سیاست دفتر تحقیقات و فناوری کمیسیون تجارت فدرال، تأکید میکند:

"انتظار نمیرود که انسانها فیلمهای خام را بررسی کنند."

اگرچه شرکت

iRobot نمیگوید که آیا ارائهدهندگان دادهها، از اینکه تصاویر آنها، بهطور ویژه توسط انسانها مشاهده میشود، آگاه بودهاند یا خیر، اگرچه اعلام میکند که فرم رضایت بهوضوح نشان میدهد که «ارائهدهندگان خدمات» این تصاویر را مشاهده خواهند کرد؟

جسیکا ویتاک

[10] دانشمند اطلاعات و استاد بخش ارتباطات دانشگاه مریلند و کالج مطالعات اطلاعات آن میافزاید:

"ما به معنای واقعی با ماشینها، متفاوتتر از انسانها رفتار میکنیم."

پذیرش یک جاروبرقی کوچک بامزه با اذعان به اینکه در فضای خانه من حرکت میکند بسیار راحتتر از این است که بپذیرید فردی در خانهتان با دوربین قدم بزند. غافل از آنکه این اساساً همان چیزی است که در حال رخ دادن است! این فقط یک روبات نیست که شما را در توالت تماشا میکند، ممکن است فرد دیگری نیز از این طریق در حال تماشا باشد.

بینایی کامپیوتر به دوربینهایی با کیفیت بالا بستگی دارد و بر طبق آمار، حدود دوازده شرکت دوربینهای جلویی را در روبات جاروبرقی خود برای جهتیابی و تشخیص اشیا و همچنین نظارت بر خانه قرار دادهاند. کریس جونز، مدیر ارشد فناوری

iRobot میگوید:

"بینایی کامپیوتری به روبات اجازه میدهد تا دادههای جهان اطراف خود را بهطور تمام و کمال ببیند. بنابراین روبات در حین تمیزکاری از رفتن روی سیم اجتناب میکند یا میفهمد چیزی که با آن روبهرو شده یک کاناپه است."

اما برای اینکه بینایی کامپیوتری در روبات جاروبرقی بتواند کاملاً مطابق با هدف کار کند، سازندگان باید آن را بر روی مجموعههای دادهای با کیفیت بالا و متنوع که بازتاب وسیعی از آنچه ممکن است ببینند، آموزش دهند. وو ارکی

[11]، مدیر ارشد تحقیق و توسعه

Roborock مستقر در پکن میگوید:

"تنوع محیطهای خانگی موضوعی پردردسر است. (مثلاً) سیستمهای جادهای کاملاً استاندارد هستند، بنابراین کار برای سازندگان خودروهای خودران آسان است زیرا میدانند خط جادهای و علائم راهنمایی و رانندگی در همهجا یکسان است؛ اما فضای داخلی هر خانه بسیار متفاوت از یکدیگر است. وجود مبلمان در جاهای مختلف استاندارد مشخصی ندارد. نوع وسیلههایی که روی زمین افتاده قابل پیشبینی نیست. گاهی اوقات یک جوراب است و شاید چند سیم (درحالیکه سیمها ممکن است در ایالاتمتحده و چین متفاوت به نظر برسند)."

بیش از 95 درصد از مجموعه دادههای تصویری شرکت

iRobot از خانههای واقعی به دست میآید که ساکنان آن خانهها یا کارمندان

iRobot هستند یا داوطلبانیاند که توسط فروشندههای داده شخص ثالث، استخدام شدهاند (که شرکت از شناسایی آنها جلوگیری نموده است). طبق بیانیه این شرکت، افرادی که از دستگاههای توسعهیافته استفاده میکنند، با موافقت خود به

iRobot اجازه میدهند اطلاعاتی ازجمله ویدئو را در هنگام کار جمعآوری و تبادل کند. چنین موافقتهایی اغلب در ازای «مشوقهایی برای مشارکت» صورت میپذیرد. شرکت از مشخص کردن چیستی مشوقها خودداری کرده و فقط اظهار داشته که آنها بر اساس مدت و پیچیدگی جمعآوری دادهها متفاوت هستند.

همچنین

iRobot این فرصت را به مشتریان دائمی خود ارائه کرده تا از طریق برنامه این شرکت در دادههای آموزشی مشارکت نموده و تصاویر خاصی از موانع را برای بهبود الگوریتمهای آن به سرورهای شرکت ارسال کنند.

iRobot میگوید که اگر مشتری در این آموزش "

user-in-the-loop" شرکت کند، فقط تصاویر ارسالی توسط خود مشتری (نه عکسهای دیگر) توسط شرکت دریافت میشود.

اما نماینده شرکت

Baussmann، در ایمیلی اذعان داشته که هنوز چنین تصاویری برای آموزش هیچ الگوریتمی استفاده نشده است.

Roborock اظهار داشته که این شرکت برخلاف

iRobot یا تصاویر خود را در فضای آزمایشگاهی تولید میکند یا با فروشندههای شخص ثالث در چین کار میکند که بهطور خاص از آنها خواسته میشود تصاویری از اشیاء را که در راستای اهداف آموزشی آنهاست، ضبط و ارائه کنند.

تیتر: مشکل اساسی این است که چهره شما مانند رمز عبوری است که نمیتوانید آن را تغییر دهید. بهمحض اینکه کسی حالت چهره شما را ثبت کند میتواند بهطور همیشگی از آن برای پیدا کردنتان در عکسها و فیلمها استفاده کند.

اما نظارت بر چنین اقداماتی در سکوهای جمعسپاری تقریباً غیرممکن است!

بنا به اظهارنظر کوین گوئو

[12]، مدیرعامل یکی دیگر از شرکتهای این حوزه به نام

Hive، در مورد برچسبگذارانی که اطلاعات را در رسانههای اجتماعی به اشتراک میگذارند، اینکه اطلاعات منتشر شود یا نه به ارائهدهنده خدمات و تصمیم او بستگی دارد که چنین کاری را انجام دهد یا نه. گوئو در ادامه میگوید: «ما فکر نمیکنیم با توجه به نیروی کارمان کنترلهای مناسبی برای محافظت مؤثر از دادههای حساس در اختیار داشته باشیم. همچنین به این موضوع که شرکت

Hive با هیچ شرکت تولیدکننده روبات جاروبرقی کار نمیکند نیز اشاره میکند.

اولگا روساکوفسکی

[13]، محقق اصلی آزمایشگاه هوش مصنوعی بصری دانشگاه پرینستون و یکی از مؤسسان گروه

AI4ALL میگوید: «برای من

تعجبآور است که تصاویر در یک سکوی جمع سپاری به اشتراک گذاشتهشدهاند. نگهداشتن برچسب «روی رایانههای شرکت»، دادهها را بسیار امنتر نگه میدارد.

بهعبارتدیگر، تکیه بر حاشیهنویسان داده بهصورت دور کار، راهی امن برای محافظت از دادهها نیست. پیت واردن

[14]، محقق برجسته بینایی کامپیوتر و دانشجوی دکترا در دانشگاه استنفورد، میگوید: «دادههایی که از مشتریان دریافت میشود، معمولاً در یک پایگاه داده با سطح معینی از محافظت در برابر دسترسی قرار میگیرند». اما با آموزش یادگیری ماشین، دادههای مشتری همگی «در یک دسته بزرگ» ترکیب میشوند و «دایره افرادی» را که به آن دسترسی دارند، گسترش مییابد.

بهنوبه خود،

iRobot میگوید که تنها زیرمجموعهای از تصاویر آموزشی را با حاشیه نویسان داده به اشتراک میگذارد، آنها هر تصویری را با اطلاعات حساس نشانهگذاری نموده، و در صورت شناسایی اطلاعات حساس، به افسر ارشد حریم خصوصی شرکت اطلاع میدهند. باوسمن این وضعیت را "نادر" مینامد و اضافه میکند که زمانی که چنین اتفاقی رخ دهد یعنی دادهای با نشانه اطلاعات حساس برچسب بخورد، "کل گزارش ویدئو و تصاویر مربوط به آن، از سرورهای

iRobot حذف میشود."

این شرکت تصریح کرده ساختاری مدنظر قرارگرفته تا: "هنگامیکه تصویری درجایی ضبطشده که حاوی مواردی ازجمله برهنگی یا سایر موارد کاملاً خصوصی باشد، همه تصاویر مربوط به آن حذف میگردد"، درحالیکه مشخص نشده این علامتگذاری و حذف توسط کاربر انسانی انجام میشود یا الگوریتمها برای برچسبگذاری این موارد اقدام میکنند. بااینوجود سؤالی که مطرح میگردد این است که پس چطور چنین اتفاقی برای فردی که تصویر او در توالت منتشرشده، اتفاق نیفتاده است.

نکته دیگری که مطرح میگردد این است که چهرهها در این برچسبگذاری دارای حساسیت نبوده، حتی زمانی که فرد زیر سن قانونی باشد.

باوسمن در ادامه توضیح میدهد:"برای اینکه روباتها یاد بگیرند از انسانها تصویربرداری نکرده و آنها را در نظر نگیرند، باید ابتدا این سیستمها با ماهیت انسان آشنا شوند که لازمه آن استفاده از دادههای مربوط به انسانها (که شامل چهره نیز میشود)، خواهد بود.

اما در رابطه با این نظریه، ویلیام بکسی استاد علوم کامپیوتر و مدیر آزمایشگاه بینایی روباتیک تگزاس مدعی شده که ممکن است تصاویر چهره برای الگوریتمهایی که به تشخیص انسان میپردازند واقعاً ضروری نباشد.

وی میافزاید: "اگر شرکت بزرگی نگران حریم خصوصی بود، میتواند تصاویر را از پیش، پردازش کند. بهعنوانمثال، میتوان چهرهها را پیش از ارائه دیتاست برای برچسبگذاری از دستگاه محو کرد".

او در پایان میگوید: «به نظر میرسد این کار خصوصاً زمانی که افراد زیر سن قانونی نیز در فیلمها حضور دارند، کمی نامرتب و شلخته انجام شود».

در رابطه با تصویر منتشرشده از یک زن در توالت، برچسبدهنده اطلاعات با قرار دادن دایرهای سیاه روی صورت او تلاش نموده تا حریم خصوصی کاربر را حفظ کند. اما در هیچیک از تصاویر دیگر منتشرشده، هویت افراد چه توسط خود برچسبدهندههای داده، چه توسط

Scale Al یا توسط

iRobot مخفی نشده است که این شامل تصویر پسر جوانی که روی زمین دراز کشیده نیز میشود.

باوسمن توضیح داد که

iRobot با جدا کردن تمام اطلاعات شناسایی از تصاویر از "هویت این انسانها" محافظت میکند، بنابراین اگر تصویری توسط عاملی خرابکار به دست آید، آنها نمیتوانند برای شناسایی شخص در تصویر از نگاشت رو به عقب استفاده کنند.

بنا به استدلال واردن ضبط تصویر چهرهها ذاتاً نقض حریم خصوصی است. او میگوید: «مشکل اساسی این است که چهره شما مانند رمز عبوری است که نمیتوانید آن را تغییر دهید. هنگامیکه شخصی مشخصه صورت شما را به دست آورد، میتواند تا همیشه از آن برای پیدا کردن شما در عکسها یا ویدیوها استفاده کند.»

جسیکا ریچ

[15]، وکیل حریم خصوصی که بین سالهای 2013 تا 2017 بهعنوان مدیر دفتر حمایت از مصرفکننده «

FTC» کار میکرد، میگوید: «قانونگذاران و مجریان حریم خصوصی، به خصوصیات بیومتریک ازجمله چهرهها بهعنوان اطلاعات حساس مینگرند». این امر بهویژه در مواردی که افراد زیر سن قانونی در دوربین ظاهر میشوند، صادق است. او میافزاید: «دریافت رضایت از کارمند [یا آزمایندگان] با گرفتن رضایت از کودک یکسان نیست. کارمند صلاحیت رضایت دادن به اطلاعاتی که مربوط به افراد دیگر است را ندارد، چه رسد به کودکان که به نظر میرسد در این قضیه دخیل هستند.» ریچ میگوید که در این اظهارات به هیچ شرکت خاصی اشاره ندارد.

میلاگروس میسلی، جامعهشناس و دانشمند کامپیوتر که جزو مصاحبهکنندگان با کارگران شرکتهای حاشیهنویسی دادهها بوده، مینویسد: «بهطورقطع مشکل واقعی این نیست که برچسبزنان داده تصاویر را در رسانههای اجتماعی به اشتراک گذاشتهاند، بلکه مشکل آن است که این نوع مجموعه آموزشی هوش مصنوعی (بهطور خاص به تصویر کشیدن چهرهها) بسیار همهگیرتر از آن شده که حتی مردم توان درک آن را داشته باشند. میسلی بخشی از یک تیم تحقیقاتی بوده که با برچسبزنان متعددی صحبت کرده و آنها نیز اظهار داشتهاند تصاویر مشابهی را دیدهاند که از بدن برهنه افراد گرفتهشده و گاهی اوقات افراد را در مراحل مختلف درآوردن لباس نشان میدهد.

او میافزاید برچسبزنان داده این مسئله را بسیار ناراحتکننده عنوان کردهاند.

در این بخش به اظهارنظرهای متفاوت متخصصین حوزه کامپیوتر پرداخته شد. اما سؤالی که هماکنون مطرح میگردد این است که چرا کاربران با وجود آگاهی از جمعآوری اطلاعات، همچنان به استفاده از این ابزارها ادامه میدهند و اینکه آیا این استفاده تنها به روباتهای جاروبرقی هوشمند محدود میشود یا خیر؟ در بخش بعدی به این سؤالات پرداختهشده و مسائل حریم خصوصی کاربران در سایر حوزهها نیز بررسی میگردد.

ادامه دارد ...

زهرا خاکسار[16]

گروه مطالعات اخلاقی پژوهشگاه فضای مجازی

[3] Northeastern University

[16] سطح 2 جامعه الزهرا، کارشناسی ارشد فلسفه و کلام دانشگاه علامه طباطبایی