سرمایهگذاری «هوش مصنوعی مسئول»، به عنوان یک اکوسیستم در حال رشد، متعهد است تا به سازمانها برای نظارت و تثبیت مدلهای هوش مصنوعی، کمک کند.

به گزارش

پژوهشگاه فضای مجازی؛ یکی از اقدامات مؤثر در این رابطه، کار رومان چوودوری

[1]، است. کار او شامل ترجمههای زیادی بوده است. وی به عنوان رهبر "هوش مصنوعی مسئول"، در شرکت مشاوره

Accenture، با مشتریانی کار میکرد که در حال تلاش برای درک مدلهای هوش مصنوعی خود بودند. آنها از کجا باید میفهمیدند که آیا این مدلها همان کاری را انجام میدهند که برای آن تولید شدهاند، یا نه؟ سردرگمی اغلب به این دلیل مطرح میشد که نحوه ارتباط دانشمندان داده، وکلا و مدیران شرکت طوری بود که به نظر میرسید هر کدام به زبانهای مختلفی صحبت میکنند. تیم او به عنوان یک تیم واسطه، طوری عمل میکرد تا همه طرفین بتوانند مدل یکسانی را دریافت کنند. اما این سیستم ناکارآمد بود، زیرا رسیدن به یک مدل واحد ممکن بود ماهها به طول انجامد.

بنابراین در نهایت سال 2020، چوودوری پست خود را ترک کرد تا فعالیت سرمایهگذاری خود را آغاز کند. این سرمایهگذاری که با نام

Parity AI، شروع به کار کرد، یک پلتفرم ارزیابی دقیق برای بررسی مدلهای هوش مصنوعی و یادگیری ماشین ارائه میدهد، که امکان ایجاد استراتژیهای ریسک، عدالت، شفافیت و توضیحات الگوریتمی و فرآیندی را با استفاده از پردازش زبان، فراهم میکند. این سیستم، به مشتریان مجموعهای از ابزارها را پیشنهاد میدهد تا بتوانند روند کار ساخت مدل را به چند هفته کاهش دهند. این روش، ابتدا به آنها کمک میکند تا مشخص کنند که چگونه میخواهند به مدل رسیدگی کنند – به صورت متعصبانه یا مبتنی بر رعایت قوانین؟ - و سپس توصیههایی برای رسیدگی به این مسئله ارائه میدهد.

سیستم

parity، یکی از محصولات در حال رشد در بین استارتآپهایی است که به دنبال راههایی برای توسعه، نظارت و اصلاح مدلهای هوش مصنوعی خود هستند. آنها طیف وسیعی از محصولات و خدمات را از ابزارهای کاهش تعصبات تا سیستمهای توضیح پذیر ارائه میدهند. در ابتدا بیشتر مشتریان آنها از صنایع بسیار سازمانیافته، مانند امور مالی و بهداشت و درمان بودند. اما افزایش تحقیقات و توجه رسانهها به موضوعات تعصب، حریم خصوصی و شفافیت، باعث تغییر تمرکز از این حوزه به سایر حوزهها شده است. مشتریان جدید اغلب تنها نگران این هستند که ارائهدهندگان محصولات هوش مصنوعی، مسئولیتپذیر باشند، در حالیکه برخی دیگر خواهان "اثبات آینده

[2]" خودشان در پیشبینی مقررات هستند.

چوودوری می گوید: بسیاری از شرکتها واقعاً برای اولین بار است که با این مسئله روبرو هستند و تقریباً همه آنها برای رسیدگی به این مسائل، درخواست کمک میکنند.

از ریسک تا اثرگذاری

هنگام کار با مشتریان جدید، چوودوری از به کار بردن اصطلاح «مسئولیتپذیری

[3]» اجتناب میکند. این واژه بیش از حد بد و نامفهوم است و فضای زیادی برای ارتباطات نادرست باقی میگذارد. او به جای آن، با زبان سادهتر و آشناتر برای شرکتها شروع میکند:

ایده ریسک. بسیاری از شرکتها، دارای ساز و کارهای ریسک و انطباق هستند و در این راستا، فرایندهایی را برای کاهش ریسک ایجاد کردهاند.

کاهش ریسک در حوزه هوش مصنوعی نیز تفاوت چندانی ندارد. یک شرکت باید با در نظر گرفتن موارد مختلفی که در رابطه با آن نگران است، کار را شروع کند. این موارد میتواند شامل

ریسکهای قانونی نظیر احتمال قانونشکنی؛

ریسکهای سازمانی، مثل امکان از دست دادن کارمندان؛ یا

ریسک از دست دادن اعتبار، مانند احتمال وقوع یک رسوایی، در حوزه روابط عمومی باشد. از این نقطه، شرکت میتواند رو به عقب کار کند تا تصمیم بگیرد چگونه سیستمهای هوش مصنوعی خود را به درستی، تنظیم کند تا از این موارد جلوگیری شود. به عنوان مثالهایی در این رابطه، میتوان یک شرکت مالی که تحت قوانین وامدهی منصفانه در ایالاتمتحده کار میکند، را مثال زد که قصد دارد مدلهای وامدهی خود را طوری تنظیم کند تا ریسکهای قانونی که ممکن است رخ دهد را، به حداقل برساند. همچنین میتوان به یک شرکت خدمات از راه دور، که سیستمهای آن بر روی دادههای پزشکی حساس آموزش میبینند، اشاره کرد. این شرکت ممکن است برای کاهش ریسکهای حوزه اعتبار خود، تنظیماتی در راستای تأمین امنیت بیشتر برای حفظ حریم خصوصی انجام دهد.

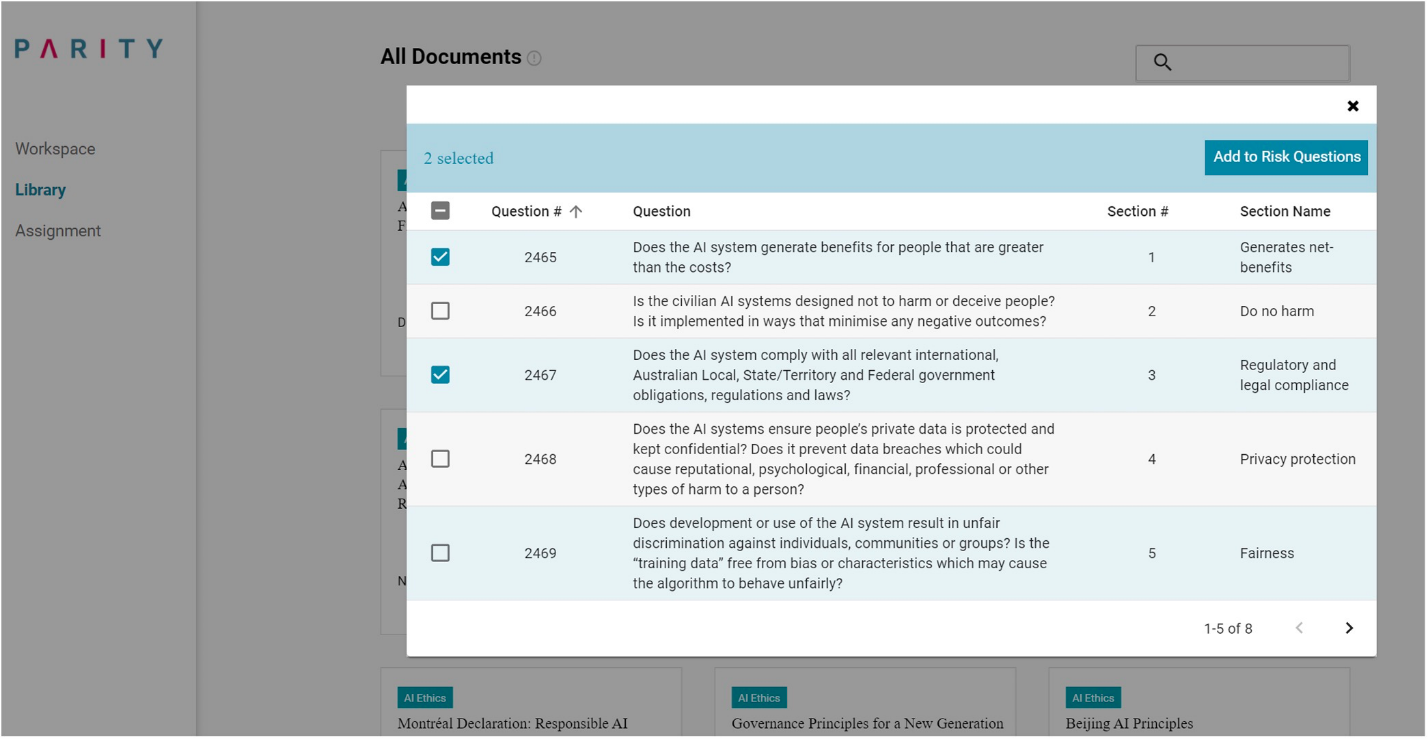

شکل

شکل:

Parity شامل کتابخانهای از سؤالات پیشنهادی که به شرکتها کمک میکند ریسک مدلهای هوش مصنوعی خود را ارزیابی کنند.

با توجه به کاربردهای فوق، سیستم

Parity، به سازماندهی این فرآیندها، کمک میکند. این پلتفرم ابتدا از شرکت میخواهد که یک ارزیابی تأثیر درونی

[4] را که در اصل، مجموعهای از سؤالات نظرسنجی باز در مورد چگونگی عملکرد سیستمهای تجاری و هوش مصنوعی آن است، ایجاد کند. این برنامه، میتواند برای نوشتن سؤالات متداول و یا انتخاب آنها، از کتابخانه

parity، که توسط همین ابزار ارائه میگردد نیز، استفاده کند. این کتابخانه شامل بیش از ۱۰۰۰ درخواست مطابق با دستورالعملهای اخلاقی هوش مصنوعی و قوانین مربوطه از سراسر جهان است. هنگامیکه مجموعه سؤالات ارزیابی ایجاد شد، کارمندان در سراسر شرکت برای پر کردن این فرمها، براساس عملکرد شغلی و دانش خود، تشویق میشوند. سپس پلتفرم، پاسخهای دریافتی را از طریق یک مدل پردازش زبان طبیعی اجرا میکند و آنها را با نگاهی به حوزههای کلیدی و پر اهمیتتر در مورد ریسک های شرکت، ترجمه میکند. به عبارت دیگر، ابزار

parity، به عنوان یک واسطه جدید بین دانشمندان و حقوقدانان عمل میکند و در نهایت، یک مدل مشابه به طرفین عرضه میکند.

در مرحله بعد، پلتفرم مجموعهای از اقدامات مربوط به کاهش ریسک را پیشنهاد میکند. این موارد میتواند شامل ایجاد یک داشبورد برای نظارت مستمر بر دقت یک مدل، یا پیادهسازی رویههای مستندسازی جدید، برای پیگیری چگونگی آموزش مدل و تنظیم مناسب آن، در هر مرحله از توسعه باشد. همچنین مجموعهای از چارچوبها و ابزارهای منبع باز، مانند

IBM’s AI Fairness 360[5]، برای نظارت بر جهتگیری و تعصبات مدل، کارتهای مدل گوگل

[6] برای مستندسازی، و هر ابزار دیگری را که ممکن است به آنها کمک کنند، ارائه میدهد. بنابراین از طریق این ابزارها، میتوان ریسکهای موجود نظیر آموزش اشتباه مدلها و یا خطر سوءاستفاده از آنها را کاهش داد.

چوودوری اظهار امیدواری میکند که اگر شرکتها بتوانند زمان لازم برای حسابرسی مدلهای خود را کاهش دهند، مدیریت و کنترل بیشتری خواهند داشت و میتوانند در امور رسیدگی و حسابرسی به مدل، مرتب و منظم عمل کنند. وی امیدوار است که با گذشت زمان، این امر بتواند ذهن آنها را به سمت تفکری فراتر از کاهش ریسک، سوق دهند. او میگوید:

«هدف هوشمندانه من، این است که شرکتهای بیشتری، به جای تمرکز بر روی ریسکها، به تأثیرگذاری در حوزه هوش مصنوعی، بیاندیشند. ریسک، زبانی است که امروزه مردم آن را میفهمند و این بسیار ارزشمند است، اما ریسک اغلب واکنشپذیر و پاسخگو است. در حالیکه تأثیرگذاری، با اهمیتتر است و در واقع، این روش، بهترین راه برای شکلدهی کاری است که باید انجام دهیم.»

اکوسیستم مسئولیت پذیری

در حالی که

parity، بر مدیریت ریسک تمرکز دارد، یک شرکت تازه تأسیس دیگر به نام

Fiddler، وجود دارد که بر روی قابلیت توضیحپذیری

[7]، تمرکز دارد. کریشنا گید

[8]، مدیر عامل این شرکت، زمانیکه به عنوان مدیر مهندسی در تیم سرویس خبری فیسبوک فعالیت میکرد، در مورد نیاز به شفافیت بیشتر در نحوه تصمیمگیری مدلهای هوش مصنوعی، فکر میکرد. پس از انتخابات ریاستجمهوری در سال ۲۰۱۶، این شرکت، یک حرکت و تلاش داخلی بزرگ را برای درک بهتر نحوه عملکرد الگوریتمهای خود، در حوزه رتبهبندی محتوا، آغاز کرد. ابزار داخلی که تیم گید، ایجاد کرد، بعدها به عنوان پایهای برای ویژگی جدید فیسبوک تحت عنوان "چرا من این مطلب را میبینم؟"

[9]، در نظر گرفته شد.

گید، اندکی پس از آن، در اکتبر 2018، فیدلر را راهاندازی کرد. این ابزار، به تیمهای علوم داده کمک میکند تا عملکرد مدلهای خود را ردیابی کنند و براساس نتایج، گزارشهای سطح بالایی را برای مدیران اجرایی، ایجاد کنند. در صورتیکه دقت مدل در طول زمان خراب شود، یا رفتارهای جانبدارانهای را نشان دهد، فیدلر، به شما در اشکالزدایی این موارد، کمک میکند تا دلیل وقوع این رفتارها مشخص شود. گید، مدلهای نظارتی و بهبود وضعیت را اولین گام برای توسعه و بکارگیری هدفمند هوش مصنوعی میداند.

دو شرکت دیگر نیز مشابه شرکت فیدلر، پلتفرمهای پایش و نظارت، ارائه میدهند. شرکت آرتور

[10]، که در سال ۲۰۱۹ تأسیس شد و شرکت دیگری با نام

Weights & Biases، که در سال ۲۰۱۷، تأسیس گردید. شرکت آرتور، مانند فیدلر، بر توضیحپذیری و کاهش تعصبات تأکید میکند، در حالیکه

Weights & Biases، آزمایشهای یادگیری ماشین را به منظور بهبود قابلیت تکرارپذیری

[11] تحقیق، دنبال میکند. هر سه شرکت، شاهد تغییر تدریجی دغدغههای اصلی شرکتها، از سمت رعایت قانون یا نحوه عملکرد مدل به سمت اصول اخلاقی و مسئولیتهای حوزه اخلاق، بودهاند.

لیز او سالیوان

[12]، معاون بخش هوش مصنوعی مسئول، در شرکت آرتور، که به عنوان مدیر فنآوری پروژه نظارت بر اشتباهات فنآوری، در یک سازمان فعال نیز عمل میکند، میگوید: "حس بدبینانه من در ابتدای کار، نگران بود که مشتریان وارد بازار شوند و فکر کنند که میتوانند به کمک این ابزار و تنها از طریق تیک زدن بعضی فرمها و ارتباطی که بین نام تجاری آنها با افراد دیگر برقرار است، هوش مصنوعی مسئول را روی مدلهای خود، پیادهسازی کنند.

«اما بسیاری از مشتریان آرتور، سعی کردهاند فراتر از اصلاحات فنی، در مورد ساختارهای حاکمیت خود بیاندیشند و برای نزدیک شدن به یک طرح جامع تلاش کنند. او میگوید: "دیدن اینکه آنها واقعاً برای انجام کار درست، سرمایهگذاری کردهاند، بسیار هیجانانگیز است.»

او سالیوان و چوودوری، هر دو از دیدن استارتآپهای نوپا که عملکردی مشابه آنها دارند، و خدماتی در راستای بهبود مدلهای هوش مصنوعی و پیادهسازی موارد اخلاقی در آنها، ارائه میدهند، هیجانزده هستند. او سالیوان میگوید:"فقط یک ابزار یا یک کار مشخص وجود ندارد که بخواهید برای پیادهسازی هوش مصنوعی مسئول، به انجام آن بپردازید. «چوودوری نیز با تأیید این مورد اضافه میکند:"اینکار، در حال تبدیل به یک اکوسیستم است.»

بنابراین به کمک ابزارهای پایش و نظارت بر مدلهای هوش مصنوعی، میتوان امیدوار بود عملیات نظارت بر مدلها به خوبی انجام شود و آنها در راستای آنچه برای آن برنامهریزی شدهاند، عمل کنند. علاوه براین، الگوریتمهای مورد استفاده در این ابزارها، میتوانند به کاهش ریسک و رفع خطرات اخلاقی ماشینهای هوش مصنوعی، کمک کنند.

فاطمه صالحنیا (دانشجوی ارشد هوش مصنوعی دانشگاه مالک اشتر)

تهیه شده در گروه مطالعات اخلاقی پژوهشگاه فضای مجازی

پیوند منبع

[2] .

Future-proof: روند پیش بینی آینده و توسعه روش هایی است که باعث به حداقل رساندن تأثیرات شوک ها و استرس های تغییرات آینده است. این اصطلاح معمولا در صنایعی مانند الکترونیک، صنعت پزشکی، طراحی صنعتی و ... بکار می رود.

[4].

internal impact assessment: ارزیابی تأثیر درونی، بخشی از سیاست یا چرخه برنامه نویسی در مدیریت عمومی است که می تواند دو نقش شامل، تجزیه و تحلیل آینده نگر و تجزیه و تحلیل تأثیر، پس از اعمال موارد است.

[5] .

IBM’s AI Fairness 360: این ابزار قابل توسعه، شامل مجموعهای جامع به زبان پایتون است که حاوی معیارهایی برای آزمایش مجموعه دادهها و مدل هاست که کمک میکند تا تبعیض و تعصب در مدلهای یادگیری ماشین، در طول چرخه عمر برنامه هوش مصنوعی، بررسی و گزارش شده و برای کاهش آن اقدام شود.

[6] . Google’s Model Cards

[9] .

Why am I seeing this post?: فیسبوک با استفاده از این ویژگی، به کاربران امکان این را میدهد که بدانند چرا این مطلب در بخش فید آنها نمایش داده شدهاست. هدف از این کار، افزایش شفافیت محتوای نمایش داده شده و اطلاعرسانی به کاربران در رابطه با نحوه کار الگوریتم فیسبوک، اعلام شد.