گاردین مقالهای را در تاریخ 18 شهریور در وبسایت رسمی خود منتشر کرده است که به ادعای این نشریه محتوای آن توسط پروژهی GPT-3 تولید شده است. موضوع انتخاب شده برای GPT-3، متقاعد کردن انسانها برای نترسیدن از رباتها بوده است. هر چند از زمان انتشار این مقاله هیاهوی بسیاری در فضای مجازی به راه افتاده است، ولیکن ملاحظاتی که در سرمقاله گاردین قید شده است ابهامات و مسائلی را به وجود میآورد که در ادامه به آنها اشاره خواهد شد.

گاردین

مقالهای را در تاریخ 18 شهریور در وبسایت رسمی خود منتشر کرده است

[1] که به ادعای این نشریه محتوای آن توسط پروژهی

GPT-3 (جدیدترین نسخه از پروژه مبدل زبانی بدوننظارت آزمایشگاه

OpenAI)تولید شده است. به گفته گاردین برای تولید این مقاله، ابتدا پاراگرافی نمونه (که همان بخش ابتدایی مقاله منتشر شده است) به

GPT-3 داده شده است و

GPT-3 این مقاله را با چندین پاراگراف در مورد موضوع تعیین شده ادامه داده است. موضوع انتخاب شده برای

GPT-3، متقاعد کردن انسانها برای نترسیدن از رباتها بوده است. هر چند از زمان انتشار این مقاله هیاهوی بسیاری در فضای مجازی به راه افتاده است، ولیکن ملاحظاتی که در سرمقاله گاردین قید شده است ابهامات و مسائلی را به وجود میآورد که در ادامه به آنها اشاره خواهد شد.

اول اینکه ، قضاوت دقیق خوب بودن

GPT-3 برای خوانندگان دشوار است. آیا به دلیل تلفیق پاراگرافهاست که متن انسجام بیشتری دارد؟(طبق گفته گاردین از

GPT-3 8 خروجی گرفته شده است که در نهایت با تلفیق پاراگرافهای منتخب از این 8 متن، مقاله مورد نظر منتشر شده است). آیا بدون ویرایشهای انسانی انجام گرفته، انسجام آن کمتر یا بیشتر میتوانست باشد؟

دوم، در مورد انتخاب محتوا: هوش مصنوعی انسان را نسبت به بی خطر بودن خود متقاعد کند.

ممکن است کسانی که اطلاعات زیادی در مورد

GPT-3 ندارند این باور را داشته باشند که این سیستم در واقع این باور را دارد. اما کارمندان گاردین به همین راحتی می توانستند موضوعی کاملا مخالف را برای آن انتخاب کنند.

فقط با خواندن یادداشت های پایان سرمقاله می توان درک کرد که کارکنان گاردین در خلق این قطعه چه نقشی داشته اند. این مسئله ارزش پروژه

GPT-3 را زیر سوال نمیبرد چرا که همان کاری را که از آن خواستهاند انجام می دهد. مسئله اینجاست که هیچ تلاشی برای آموزش خوانندگان در مورد آنچه

GPT-3 انجام می دهد ارائه نشده است.

همچنین بخشی از مقاله که به طور گسترده در رسانههای اجتماعی در حال پخش است همان قسمتیاست که توسط گاردین (با نقل از هاوکینگ) نوشته شده است و نه

GPT-3.

سوم: مقاله در پایان به یکباره در مورد مقالههای رد شده

GPT-3 شروع به صحبت می کند. سردبیران گاردین بودهاند که این تصمیم را گرفتهاند و آنها این امکان را داشتهاند که صدای مقاله تولیدی را منسجم تر کنند. هدف آنها از این تصمیمات تحریریه چه بوده است؟

چهارم: در حوزه پژوهشی خلاقیت محاسباتی، گاهی اوقات در مورد "ضریب گزینش" صحبت میشود. منظور از این ضریب عبارت است از تعداد دفعات اجرای یک سیستم قبل از اینکه انسان بخواهد نتایج را به اشتراک بگذارد. اگر کسی میخواد سیستمی کاملاً خودمختار و ایدهآل را ارائه دهد، این ضریب باید به 0 برسد.

می توان ضریب گزینش 8 را برای این آزمایش

GPT-3 استنباط کرد که زیاد است. حتی ابزارهای مبتنی بر هوشمصنوعی پشتیبانی از خلاقیت، ضرایب 2 تا 5 را هدف خود قرار می دهند.

البته ابهامات ذکر شده در بالا به معنای نفی پیشرفت انجام گرفته در

GPT-3 که از 175 میلیارد پارامتر در شبکه عصبی خود بهره میبرد و یک رکورد چشمگیر به حساب میآید نیست. طبق ارزیابی انجام گرفته توسط تیمی از دانشجویان دانشگاه برکلی

[2]،

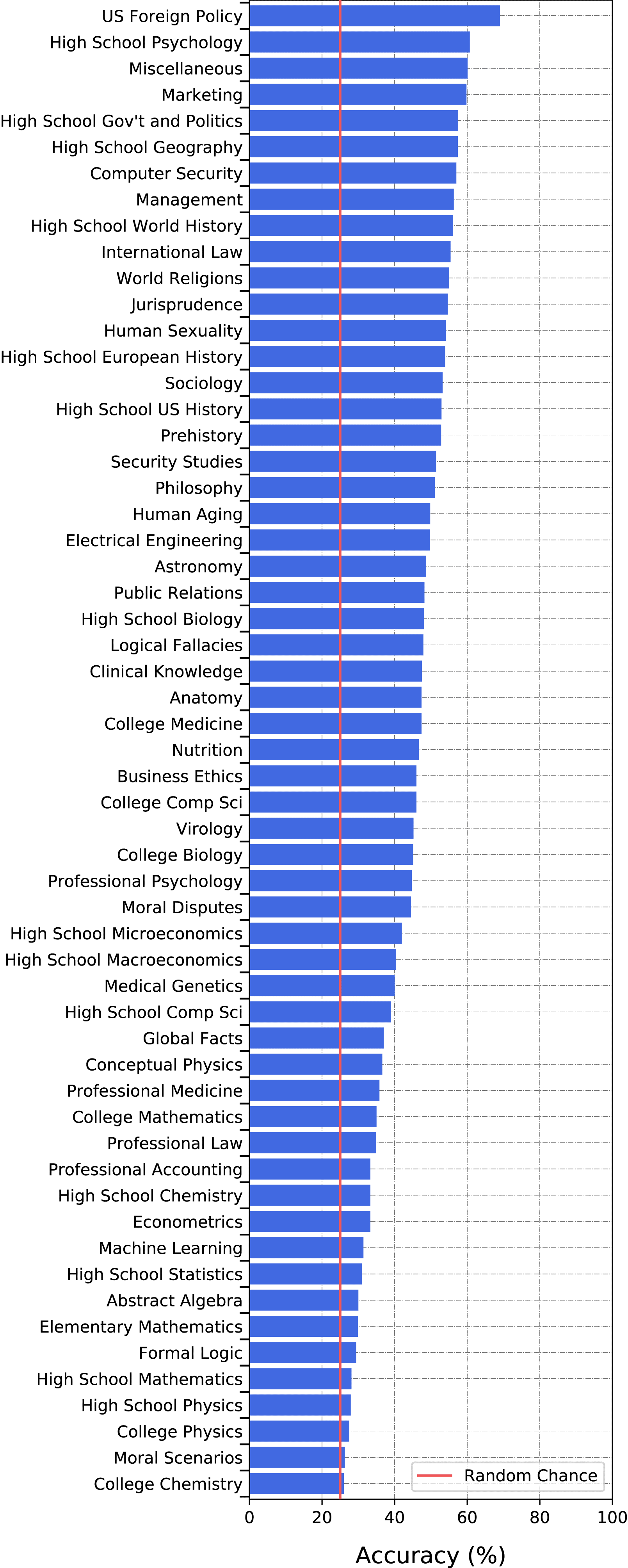

GPT-3 توانسته به 43 درصد دقت میانگین در حل مسائل مخلف برسد که فاصله نسبتا مناسبی از آستانه شانس 20 درصدی حل مسائل بنچمارک در نظر گرفته شده در این پژوهش به حساب میآید. در شکل 1 میزان دقت عملکرد

GPT-3 به تفکیک 57 حوزهی دانشی مورد آزمون نشان داده شده است. همانطور که در این تصویر مشاهده می شود،

GPT-3 با اینکه در حوزههایی چون سیاست خارجی آمریکا، روانشناسی دبیرستان، بازار، امنیت کامپیوتر و مدیریت دقت خوبی از خود نشان دهد، ولی در زمینههایی چون فیزیک و ریاضی دبیرستان و دانشگاه نزدیک به آستانه شانس عمل کرده است.

از دیگر ضعفهای مهم برشمرده شده برای

GPT-3 عدم دانش در مورد تشخیص صلاحیت علمی خود در زمینههای مختلف است. با این حساب این خطر وجود دارد که این هوش مصنوعی در حوزههایی که عملکرد خوبی ندارد ورود کرده و تصمیمگیری نماید. همچنین عدم فهم و توانایی تفکیک مناسب میان مسائل قانونی و مسائل اخلاقی، چالش دیگریست که انتظار میرود در نسخههای بعدی این پروژه با جدیت دنبال شود.

نگارنده : محمد مهدی رضاپور

نگارنده : محمد مهدی رضاپور

تهیه شده در گروه علوم و فناوریهای نوین فضای مجازی

ارجاعات

[1] https://www.theguardian.com/commentisfree/2020/sep/08/robot-wrote-this-article-gpt-3#comments

[2] https://arxiv.org/pdf/2009.03300.pdf